AIPerf:由清华大学与鹏城实验室联合研制的大规模人工智能算力基准测试程序

AI算力基准测试, 高性能计算, 自动化机器学习

AIPerf是由清华大学与鹏城实验室联合研制的大规模人工智能算力基准测试程序,旨在科学评估计算集群的AI性能。

AIPerf是什么

AIPerf是一种基于自动学习的可变规模人工智能基准评测程序,由清华大学与鹏城实验室联合研制。它专为评估大规模人工智能计算系统而设计,解决了传统基准测试程序(如Linpack)与AI计算需求不匹配的问题。AIPerf以自动化机器学习(AutoML) 为核心负载,通过网络结构搜索和超参优化来全面测试计算集群的AI算力。

AIPerf的主要功能

-

自动化算力评估:基于微软NNI开源框架实现,使用网络态射和TPE方法进行网络结构搜索和超参优化,自动寻找更优的神经网络结构和参数

-

可变规模测试:可根据集群规模动态调整问题大小,充分利用不同规模计算集群的资源

-

统一性能指标:采用Tops作为评价指标,即平均每秒处理的混合精度AI浮点操作数,方便不同系统横向比较

-

多机通信测试:包含必要的多机通信环节,如任务分发、结果收集与多机训练,将网络性能纳入评估体系

-

实际AI应用负载:目前在ImageNet数据集上训练神经网络运行计算机视觉应用,未来计划支持自然语言处理等更多AI任务

AIPerf如何收费

AIPerf作为学术研究项目,目前没有明确的商业化定价信息。该项目处于积极的开发和完善阶段。

AIPerf的应用场景

-

超算中心排名评估:用于中国超级算力大会等场合的大规模AI算力排名,如鹏城云脑二主机曾以194,527 Tops的成绩荣登榜首

-

企业集群选型:帮助企业评估不同AI计算集群的性能,为采购决策提供依据

-

科研机构研究:支持学术研究机构进行AI系统性能比较和架构优化研究

-

系统性能优化:协助系统管理员发现计算集群性能瓶颈,进行针对性优化

常见问题

- AIPERF 是什么?

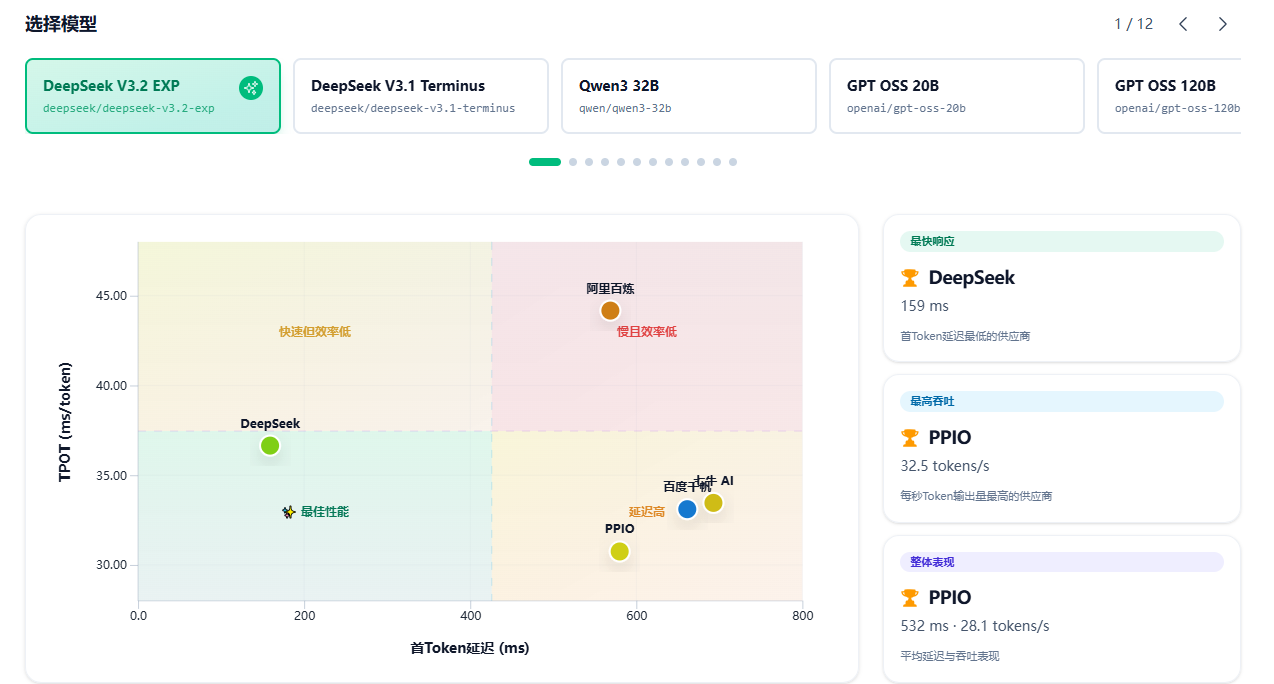

AIPERF 是一个专业的 AI 模型性能测试平台,帮助开发者和企业全面评估各类 AI 模型和服务提供商的性能表现,包括响应速度、吞吐量、稳定性等关键指标。 - 如何开始使用 AIPERF 进行性能测试?

首先需要登录平台,然后在控制台中创建性能测试任务。您可以选择要测试的模型、配置测试参数(如并发数、测试时长等),系统将自动执行测试并生成详细的性能报告。 - AIPERF 支持哪些 AI 模型和服务提供商?

我们支持主流的 AI 服务提供商,包括 OpenAI、Anthropic、Google、阿里云等。平台持续更新,不断添加新的模型和提供商支持,您可以在模型管理页面查看完整列表。 - 性能测试报告包含哪些指标?

报告包含多维度性能指标:首字节时间(TTFT)、每秒 Token 数(TPS)、延迟分布、成功率、错误率等。还提供可视化图表和对比分析,帮助您全面了解模型性能。 - 如何比较不同模型的性能?

使用我们的对比功能,可以同时选择多个模型或服务提供商进行并行测试。系统会生成对比报告,直观展示各项指标的差异,帮助您做出最优选择。 - 如何获取技术支持?

我们提供专业的技术支持服务。您可以通过平台内的帮助中心查看文档和常见问题,或联系我们的技术团队获取专属支持。企业用户可享受优先响应服务。

AIPerf目前仍处于积极开发阶段,主要面向大规模AI计算系统评测。如需了解最新功能和支持的集群类型,建议关注清华大学与鹏城实验室的官方发布。

如有更多关于AIPerf的疑问,请评论区留言;

AIPerf:由清华大学与鹏城实验室联合研制的大规模人工智能算力基准测试程序