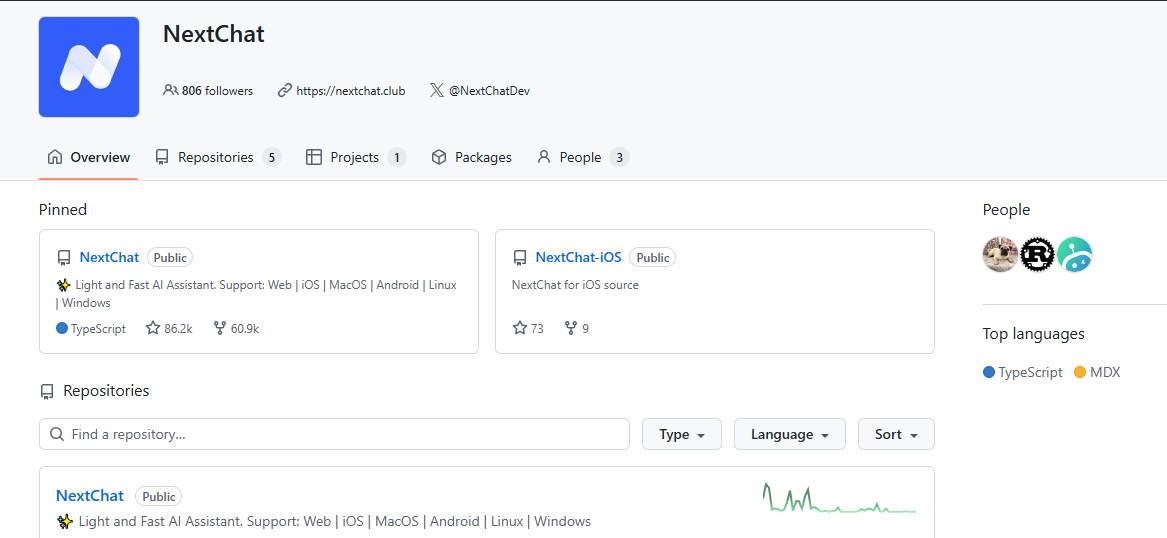

NextChat:多模型支持/隐私安全/开源跨平台AI聊天应用

NextChat(原名 ChatGPT-Next-Web)是一款在开发者中非常流行的开源跨平台AI聊天应用。它本身不是一个AI模型,而是一个优雅的前端界面,可以让你方便地接入和管理各种主流的AI大模型。

下面这个表格汇总了它的核心信息,帮你快速了解:

| 维度 | 详细说明 |

|---|---|

| 核心定位 | 开源跨平台AI聊天应用前端 / 智能协作引擎 |

| 核心功能 | 多模型支持、隐私安全、跨平台、Prompt模板、聊天记录压缩 |

| 平台与访问 | Web端、桌面客户端 (Windows/macOS/Linux, ~5MB) 及 移动端PWA |

| 费用模式 | 软件免费开源,使用中产生的API费用由对应的模型服务商收取 |

🚀 核心功能与特色

NextChat 的功能设计充分考虑了用户体验和效率,以下是它的一些亮点:

-

广泛的模型支持:你可以通过配置API Key和接口地址,接入 OpenAI GPT系列、Google Gemini Pro、Anthropic Claude,以及通义千问、DeepSeek、ChatGLM等众多国内外主流模型。这让你可以在一个统一的界面下,灵活切换和使用不同厂商的模型服务。

-

极致的轻量与快速:NextChat 非常注重性能,其客户端体积小巧(约5MB),首屏加载极快(约100KB),并支持流式实时响应,让你几乎感觉不到延迟,对话体验非常流畅。

-

强大的隐私与安全保障:所有聊天数据默认保存在本地浏览器中,不会上传到第三方服务器。对于企业用户,它还支持私有化部署,可以将服务部署在自己的服务器上,确保商业数据的安全。

-

提升效率的实用工具:

-

Prompt模板(面具):内置了大量预设的提示词模板,你也可以创建和分享自己的模板,快速进入特定对话角色(如代码审查专家、翻译助手等)。

-

自动上下文压缩:能够智能压缩冗长的历史对话,在节省Token消耗的同时,支持超长对话的进行。

-

完整的Markdown支持:在对话中完美支持LaTex公式、Mermaid流程图、代码高亮等,对技术用户非常友好。

-

🛠️ 如何部署与使用

NextChat 提供了多种灵活的部署方式,你可以根据自己的技术背景和需求选择:

| 部署方式 | 适用人群 | 特点说明 |

|---|---|---|

| Vercel一键部署 | 个人用户、初学者 | 最简单快捷,几分钟内即可完成,支持免费域名。 |

| Docker部署 | 有一定技术基础的用户、NAS玩家 | 部署简单,环境统一,易于管理和更新。 |

| 本地运行/客户端 | 追求稳定、便捷的桌面用户 | 下载即用,数据本地存储,无需部署。 |

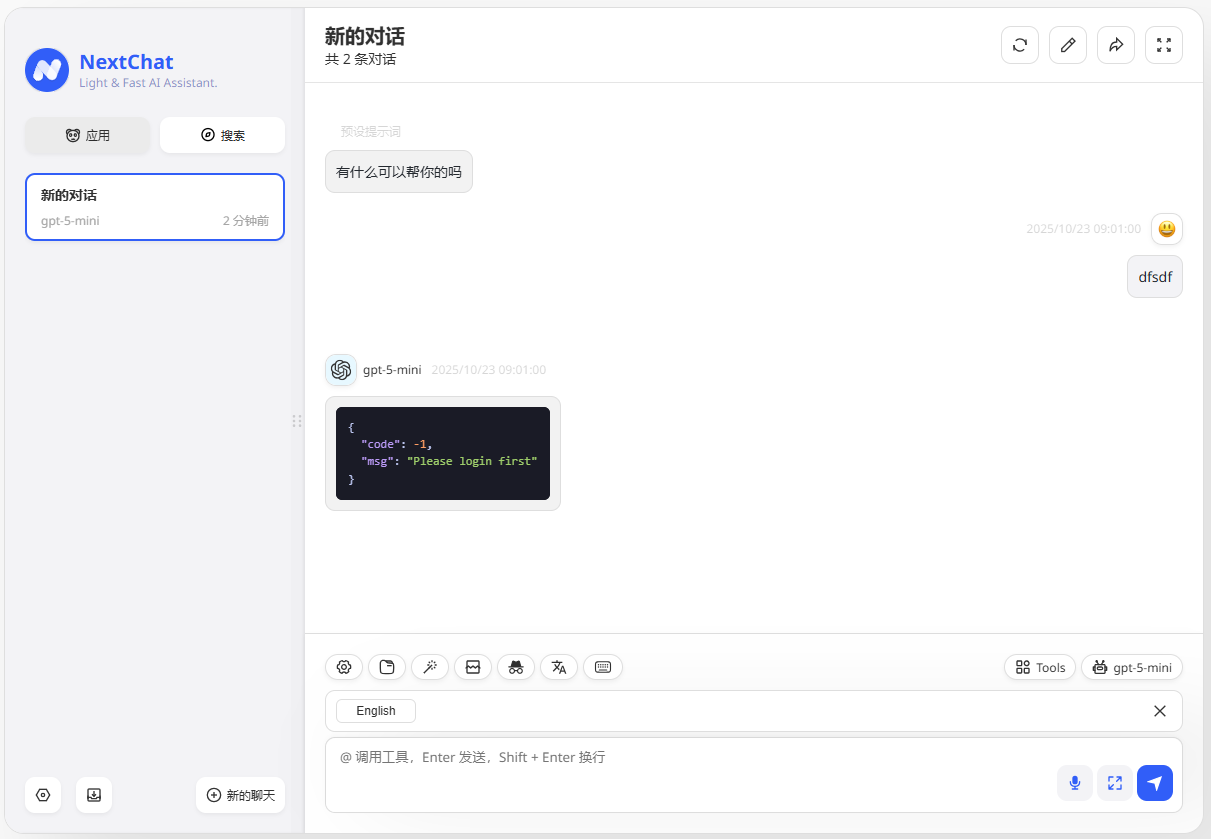

基本使用流程:

-

获取模型API:你需要首先拥有一个AI模型的API Key(例如从OpenAI、SiliconCloud等服务商处获取)。

-

部署NextChat:选择上述一种方式部署或安装NextChat。

-

配置接口:在NextChat的设置中,填入你的API Key和对应的接口地址(BASE_URL)。

-

开始对话:配置完成后,你就可以选择模型并开始聊天了。

💡 主要适用场景

-

个人与开发者:用于搭建私人的AI助手,进行学习、编程、写作和日常查询。

-

团队与企业:通过内网部署,集成内部知识库,作为团队的统一AI协作平台,提升工作效率。

-

教学与演示:由于其部署简单、界面美观,非常适合用于AI相关的教学演示和产品原型验证。

NextChat:多模型支持/隐私安全/开源跨平台AI聊天应用